OpenAI y el juego del teléfono

La nueva generación de imágenes por IA parece un poco más de lo mismo... excepto que no es más de lo mismo.

Si de repente has visto un montón de memes, fotos con estética de anime, e ilustraciones hechas con IA en redes sociales, déjame decirte que has presenciado el nacimiento de lo que posiblemente sea la herramienta democratizadora más potente desde el boom de la IA, o incluso desde la creación de internet.

Hoy, con toda la ilusión, se lo he explicado a mi madre. Pero no ha parecido muy sorprendida. Dice que ya ha visto este fenómeno de imágenes generadas con IA antes, y no le falta razón. Si tú, como ella, piensas que esto ya se podía hacer, déjame enseñarte la gran diferencia.

La parte guay

Imágenes con estética de Studio Ghibli, memes modificados, versiones de dibujos, conceptos audiovisuales... Todo esto es gracias a la nueva funcionalidad de ChatGPT-o, el modelo razonador de OpenAI. Cualquiera que lo prueba ve rápidamente la cantidad de aplicaciones y capacidades que ofrece a nivel comercial, creativo y conceptual.

En un giro de los acontecimientos, justo un (1) día después de que Google anunciara la integración de imágenes en Gemini 2.0 para editar fotos o crear nuevas, Sam Altman ha contraatacado con el producto que tenían guardadito: una funcionalidad que por fin integra totalmente imágenes tanto de inputs como outputs del modelo sin depender de DALL-E, el modelo especializado en imágenes de OpenAI. Esto significa que:

Si le pasas una imagen, ahora la “ve“ completamente, sus proporciones, detalles, colores, composición… ChatGPT ahora sí que es un modelo verdaderamente multimodal y no solo de texto/voz. Hasta ahora hacía trampas, luego explico por qué.

Puedes combinar elementos de diferentes imágenes para crear una nueva ilustración que respete el contenido original y lo combine. Por ejemplo, esto de Diego Arroyo, CEO de Laagam para crear un shooting customizado y realista en pocos minutos.

Tiene la capacidad de editar solo los aspectos que el usuario pide, sin tocar el resto de cosas. Lo que ha llevado a la viralización de los memes versión Ghibli.

Puede plasmar textos en las imágenes con diferentes estilos y tipografías de manera precisa y sin fallos ortográficos. Cosa que antes era prácticamente imposible en cualquier modelo. Es una bestialidad.

Hasta ahora, la generación de imágenes por IA era más bien un juguetito para hacer memes e ilustraciones sueltas. Pero ahora se ha convertido en una verdadera herramienta profesional gracias al control, precisión, y calidad de los resultados.

La parte fea

En su constante lucha contra Grok, de Elon Musk, OpenAI ha ablandado sus políticas de contenido. Lo que quiere decir que a partir de ahora dejará crear ilustraciones ofensivas (a discreción del usuario), permitirá usar a personas reales como protagonistas de las imágenes, o directamente copiar estilos artísticos con nombres y apellidos. Todas estas decisiones se pasan por el forro un montón de debates éticos que, ahora más que nunca, y vista la buena calidad de las imágenes, deberían ser revisados. Ya abriremos ese melón otro día.

Las trampas de ChatGPT4 vs lo nuevo de ChatGPT-o

Antes del lanzamiento de esta nueva feature, si yo le pasaba una foto a ChatGPT4, algo curioso se ejecutaba en segundo plano. Como una imagen vale más que mil palabras, nunca mejor dicho, aquí lo enseño:

Imaginemos que envío esta imagen y le pido que la convierta en un anime con el estilo de Studio Ghibli:

Nosotros en nuestra pantalla de ChatGPT veríamos esto:

User: Foto adjunta.

User: “Convierte esta foto a un anime japonés, de colores y formas suaves.”

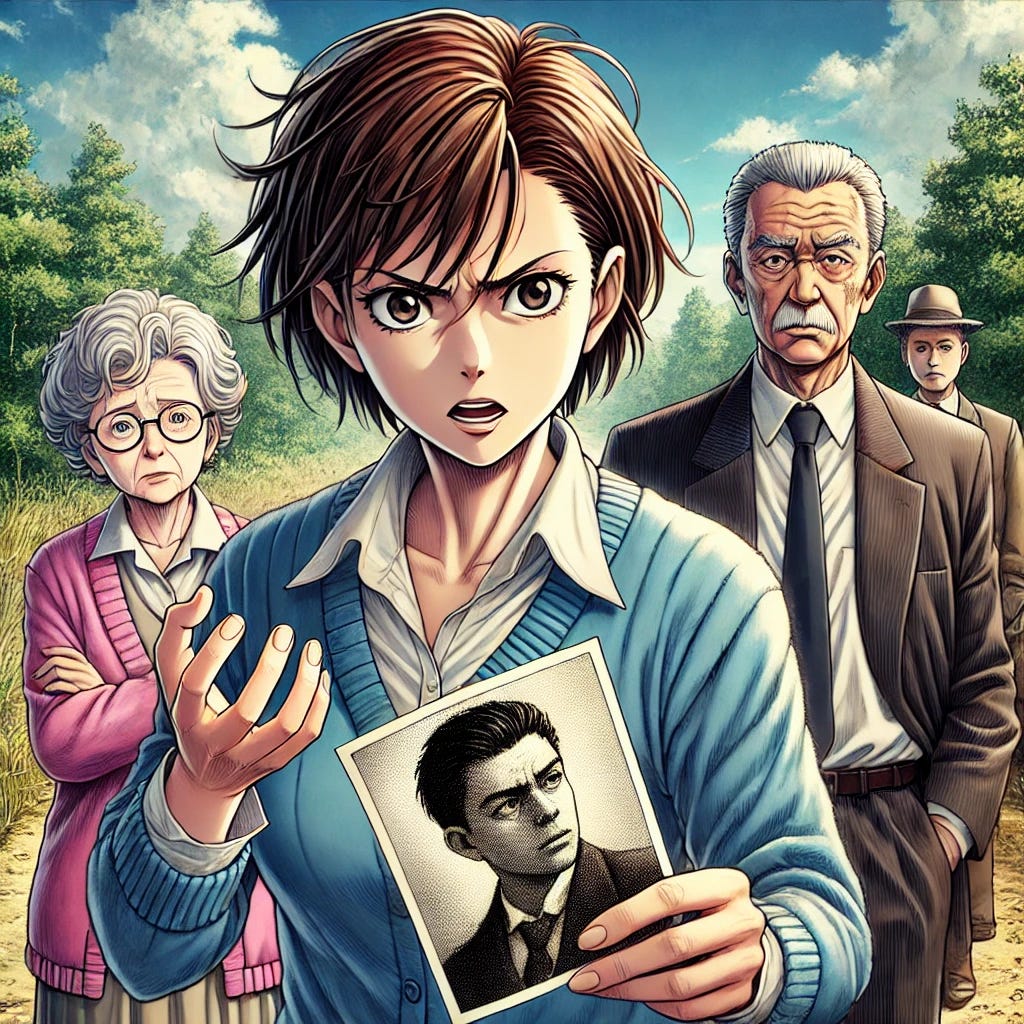

Recordemos que ChatGPT originalmente es un LLM (Large Language Model) que solo trabaja con texto. Así que cuando metes una fotografía en la conversación, el sistema tiene que describir la imagen con unas cuantas frases para poder entender qué aparece en ella. Por lo tanto, en realidad internamente el modelo lee algo como esto:

User: “Attached an image. Shows an elderly woman wearing a blue sweater and a white shirt, holding a black-and-white photograph of a man in a military uniform. She appears to be speaking emphatically, raising her hand. Next to her, there is another elderly woman wearing a pink sweater, and a man in the background observing the scene. The setting is an outdoor area with dirt and vegetation, and the sky is mostly clear with some clouds.”

User: “Convierte esta foto en un anime de colores y formas suaves.”

Lo que ha pasado es que el sistema utiliza un agente de IA interno de image-to-text, que se encarga de describir las imágenes para que el LLM entienda de qué se está hablando para seguir con la conversación.

Seguro que muchos ya estáis viendo el problema. Esto es como el juego del teléfono. El chat solo tiene una vaga idea del contenido de la imagen, ¡pero no de sus detalles!

Una vez el chat entiende que el usuario quiere crear una imagen, acude a DALL-E, el modelo text-to-image de OpenAI. DALL-E solo puede generar imágenes a partir de descripciones de texto, así que la estrategia de pasar todo a palabras le va genial.

Después de procesar la petición y de llamar a DALL-E, el resultado del chat es este:

Aunque conceptualmente es muy parecido a la imagen original, no tienen nada que ver. Podemos ver que esta imagen ha sido creada por DALL-E porque el nombre del archivo de la imagen es la descripción de lo que ChatGPT ha descrito que queremos. En este caso ha sido:

DALL·E 2025-03-27 15.45.05 - A detailed anime-style illustration of three elderly people outdoors. The central figure is an older woman with short, dark hair, wearing a blue sweat.webp

Aquí viene lo bueno

Comparemos la imagen anterior con la del nuevo modelo de ChatGPT-o, pidiéndole exactamente lo mismo:

La mejora es evidente. Ya existían muchos modelos de creación de imágenes, como DALL-E o Stable diffusion, pero no tan precisos ni con tanto control como este de ChatGPT. Esto es porque han conseguido usar técnicas de auto-regresión, algo muy difícil de conseguir hasta ahora en imágenes.

Esta funcionalidad va a ser una revolución. Si tuviera que hacer un paralelismo, antes habría sido como si alguien me pidiera hacer un dibujo, pero solo me diera con una corta descripción de lo que quiere (sin ver ejemplos ni referencias parecidas) vs. que ahora pudiera calcar la foto original, y tener una descripción exacta de cada uno de los cambios y detalles que quiere modificar de la imagen. ¡Nada que ver!

Yo ya estoy pensando en aplicaciones para usar esta vaina. Esto va a ser una locura.

¡Gracias por leerme! Si os ha gustado seguidme, dadle a like y compartidlo, un beso chaooo

pfffff todo lo que aprendo de ti <3

Brutal, Rubén!!!! 😮💨 superinteresante todo lo que cuentas